Apple está introduciendo una serie de nuevas herramientas para analizar las fotos en la cuenta de iCloud de un usuario en busca de imágenes explícitas de niños, intervenir en las búsquedas de material abusivo y bloquear el envío de imágenes explícitas a los niños.

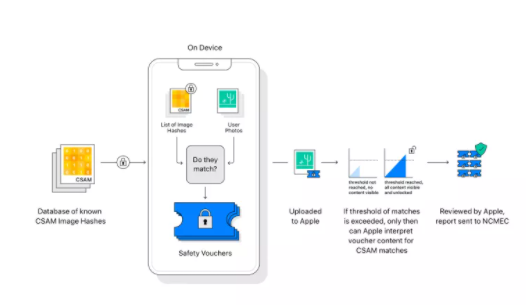

El análisis de imágenes de Apple permite a los usuarios buscar rápidamente sus fotos gracias a las herramientas de detección y reconocimiento de rostros, mientras que el software también puede ayudar a mejorar sus imágenes al reconocer el tipo de escena que está fotografiando. Haciendo uso de esta tecnología, Apple comparará las fotos de iCloud con una base de datos de imágenes y, si se encuentra un umbral de coincidencias, se enviará un informe al Centro Nacional para Niños Desaparecidos y Explotados (NCMEC).

El sistema utiliza criptografía para convertir las imágenes en un conjunto único de números, conocido como NeutralHash, que luego se puede comparar con los valores de NeutralHash de las imágenes en la base de datos de material de abuso sexual infantil. El sistema garantiza que las imágenes que no coincidan no se compartan y, según el documento técnico, el proceso tiene una tasa de error de menos de uno en 1 billón.

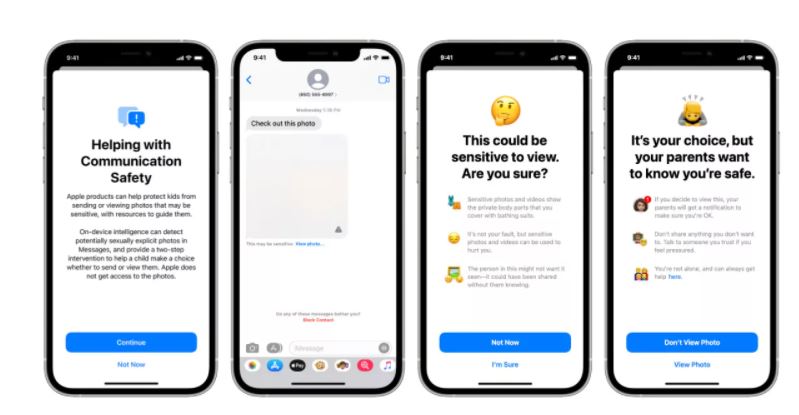

Además, Siri y las funciones de búsqueda advertirán a los usuarios que busquen material infantil abusivo, así como también proporcionarán recursos para que los usuarios presenten informes de sospechas de abuso. Los padres también podrán activar una función dentro de Apple Messages que difumina las imágenes enviadas al teléfono de su hijo que se consideren explícitas.

Las imágenes aún se pueden ver con una segunda presión, pero al elegir verlas, los padres recibirán una alerta. También habrá varias advertencias en el teléfono antes de que se muestre la imagen, lo que le dará al niño la oportunidad de cancelar sin ver la imagen.

Dale un vistazo a nuestra sección noticias